Volví recientemente de un viaje de análisis a Silicon Valley y es innegable que el auge de la IA no decae. Se pueden extraer dos grandes lecciones: los grandes modelos de lenguaje (LLM) no son una moda pasajera y la ciencia que hay detrás de la IA sigue evolucionando de formas nuevas e imprevistas.

Los LLM son una forma de cálculo completamente nueva. En su forma más básica, un LLM genera palabras en una secuencia que pronto empiezan a cobrar sentido. A un nivel más profundo, si el LLM puede organizar palabras y responder preguntas, entonces puede comunicarse y manipular conceptos intangibles. Eso es profundo. Las máquinas de Von Neumann tradicionales computan a partir de registros, funciones aritméticas y números binarios, no conceptos.

La tecnología que hay detrás de la IA está abriendo nuevos caminos. Parece que cada semana surgen nuevos trabajos de investigación que descubren enfoques más eficientes del aprendizaje automático. En los últimos meses, están dándose los primeros pasos de los denominados Selective State Space Models (SSSM), que pueden efectuar inferencias cinco veces más rápido que el enfoque de transformador de GPT-4.

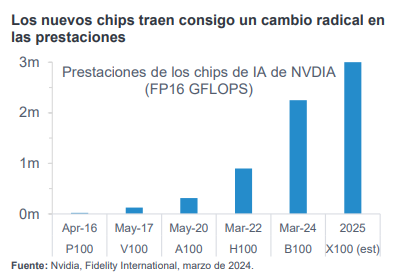

Al mismo tiempo, la tecnología de semiconductores que mueve estos sistemas está avanzando a velocidad de vértigo. En marzo, Nvidia presentó su chip de GPU más reciente, que es casi tres

veces más rápido que la alternativa más avanzada actual. A finales del próximo año, Nvidia probablemente lance su chip X100, que podría ser más de 9 veces más rápido que el A100 que se empleó para entrenar a GPT-4.

Las noticias sobre la IA han estado protagonizadas por nuevas y llamativas aplicaciones como Sora, de OpenAI, para la generación de vídeo o Stable Diffusion para generar imágenes. Sin embargo, gran parte del valor oculto va a provenir de la automatización de tareas diarias, como redactar correos electrónicos, elaborar presentaciones a clientes e incluso programas, lo que ahorrará un tiempo precioso en tareas cotidianas y lo liberará para utilizarlo en actividades de mayor valor añadido.

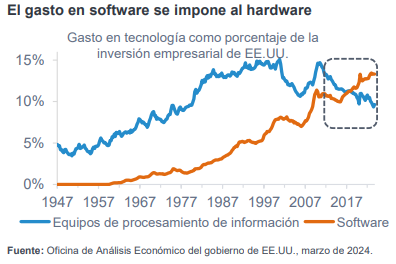

La IA también promete inclinar la balanza del gasto tecnológico del software hacia los semiconductores. Un conocido axioma en Silicon Valley es “el software se come el mundo”, refiriéndose a la tendencia de las empresas de software a quedarse con el negocio de sectores de la vieja economía, por ejemplo Uber y los taxis.

En los últimos diez años, esta idea ha evolucionado hasta el punto de que el software ha desplazado a los semiconductores y al hardware. La inversión en equipos ha disminuido como porcentaje de la inversión empresarial desde la crisis financiera mundial, pero a medida que la IA se hace omnipresente, los semiconductores, como las GPU, podrían recuperar parte de este gasto.

Lo que queda claro es que no estamos ni por asomo cerca de los límites de la tecnología de lA. Los productos seguirán siendo o exponencialmente mejores o exponencialmente más baratos. Eso beneficiará a los proveedores de las tecnologías subyacentes, no solo los chips de GPU, también los conmutadores de red, las memorias, los centros de datos y la generación eléctrica, lo que ampliará la temática. Aunque el mercado cree que la apuesta por la IA se concentra en un puñado de valores reconocidos, nuestro análisis demuestra lo contrario y que las oportunidades de inversión en la IA seguirán ampliándose conforme avance 2024.

Tribuna de Jonathan Tseng, analista de renta variable de Fidelity International